一、课程介绍

1. 课程背景

- 课程名称:MIT Introduction to Deep Learning(6.S191)

- 授课教师:Alexander Amini 等

- 课程时间:2025 年 1 月 6 日至 1 月 10 日

- 课程形式:线上线下结合,包含技术讲座和软件实验室

2. 课程目标

- 让学生理解深度学习的核心概念和原理。

- 通过实践操作,培养学生在深度学习领域的实际应用能力。

- 探讨深度学习在各个领域的应用,如计算机视觉、自然语言处理等。

二、深度学习基础

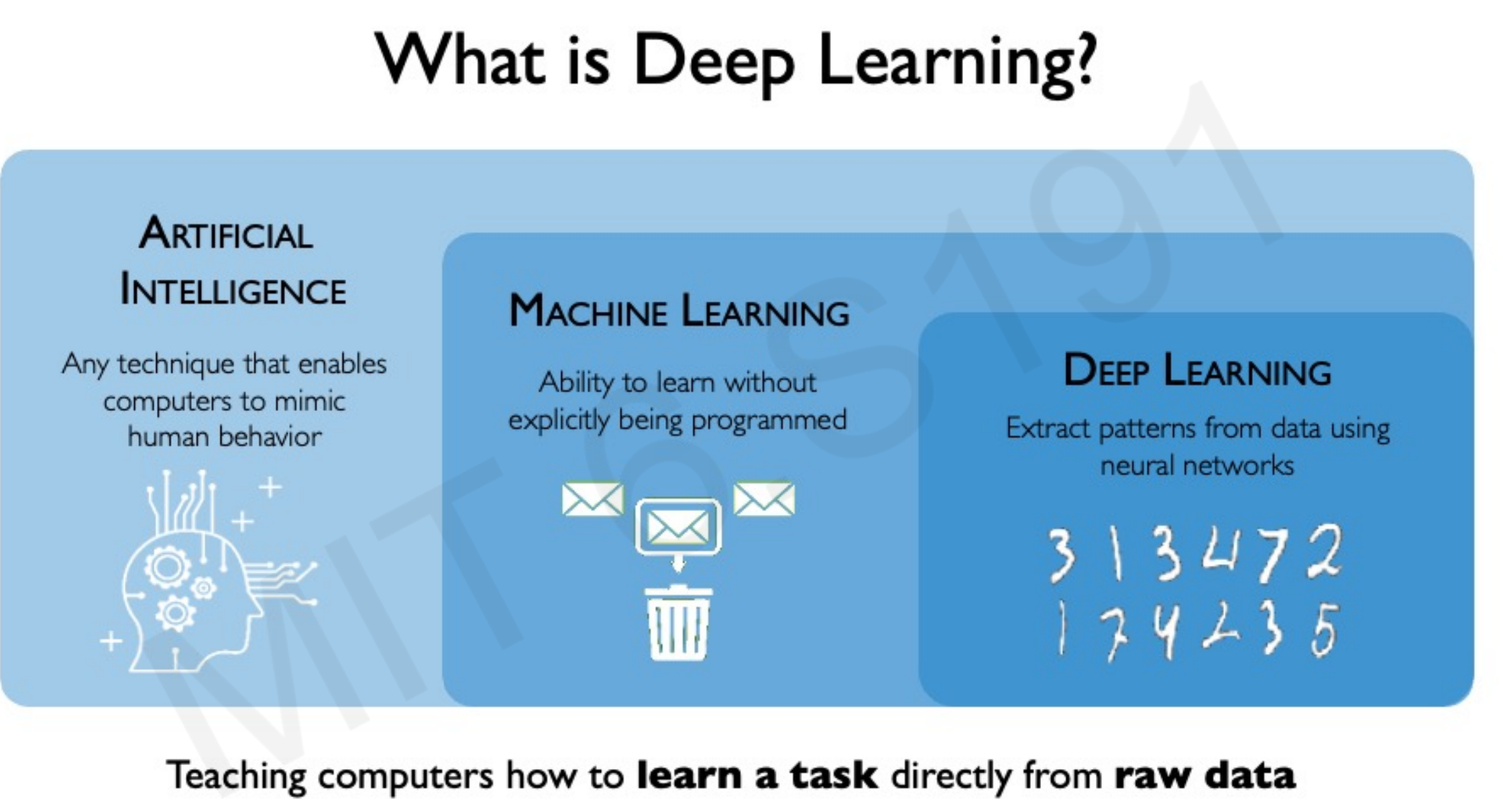

1. 什么是深度学习?

- 定义:深度学习是机器学习的一个子集,它使用人工神经网络从数据中学习,能够处理复杂的模式和大规模数据。

- 与传统机器学习的区别:传统机器学习需要手动定义特征,而深度学习能够自动从数据中学习特征。

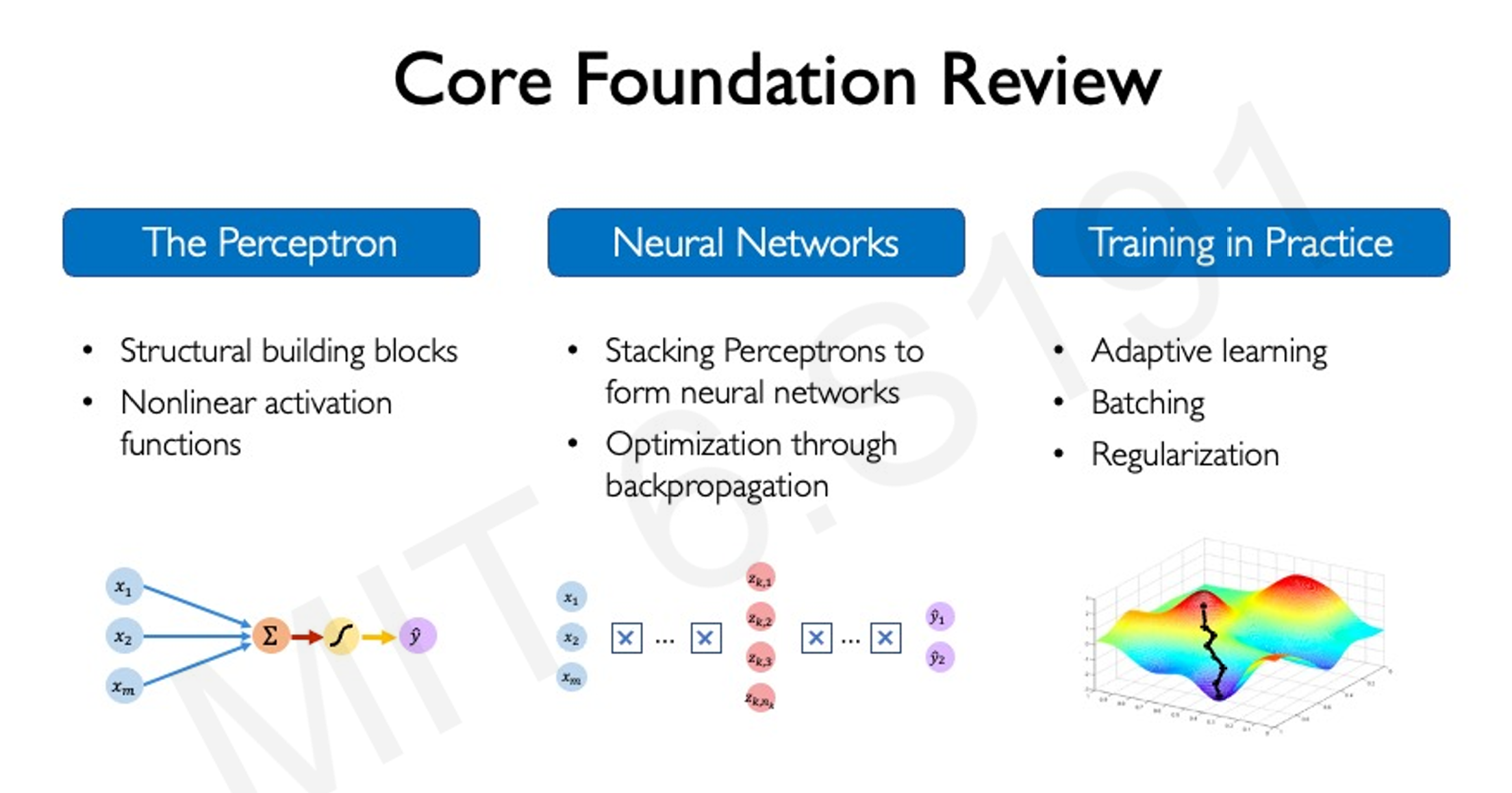

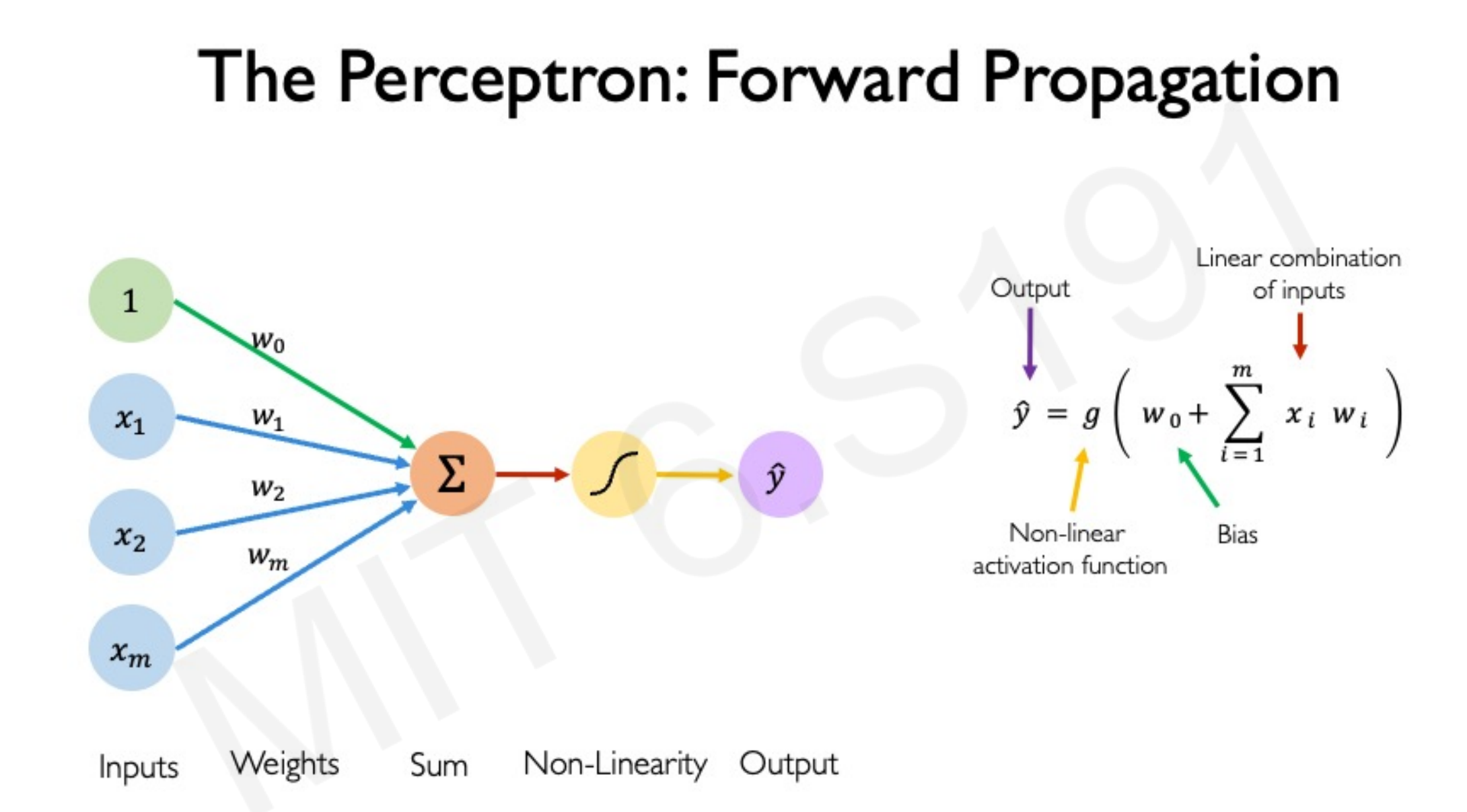

2. 神经网络的基本单元——感知机

这是一种前向传播

- 结构:由输入层、权重、偏置、激活函数和输出层组成。

- 工作原理:

- 输入层接收输入数据。

- 权重和偏置对输入数据进行线性组合。

- 激活函数引入非线性,使网络能够处理复杂的模式。

- 输出层给出最终结果。

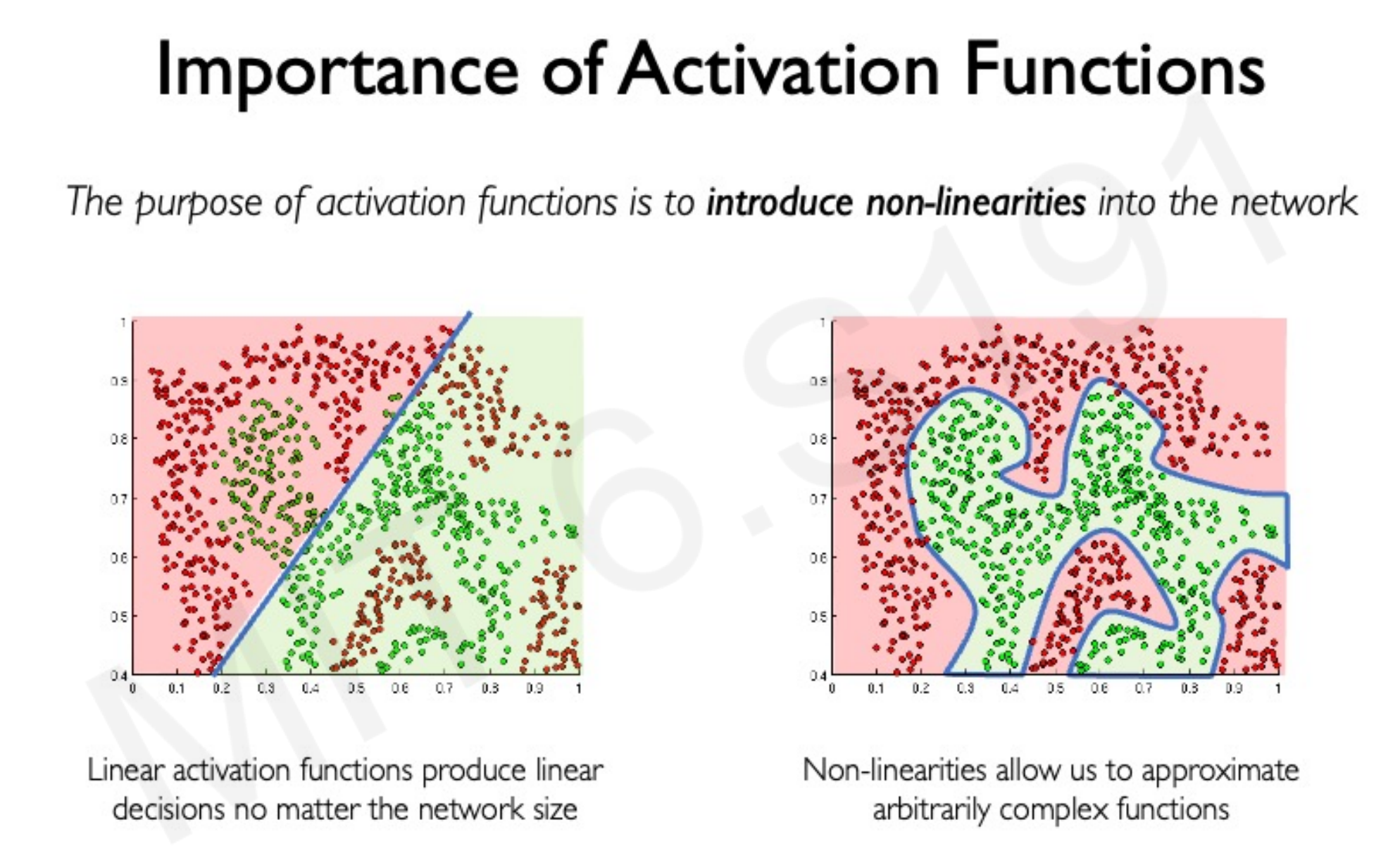

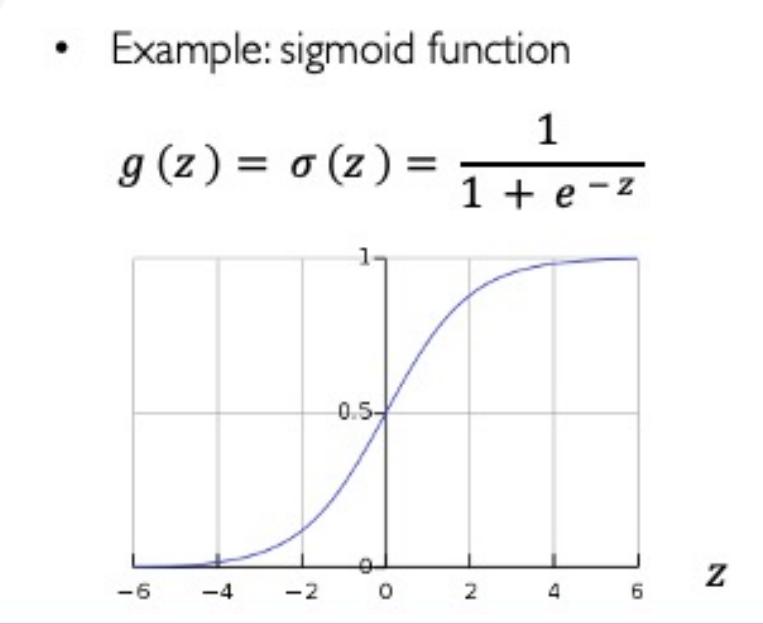

3. 激活函数

-

作用:引入非线性,使神经网络能够近似任意复杂的函数。

- 现实世界是普遍非线性的

-

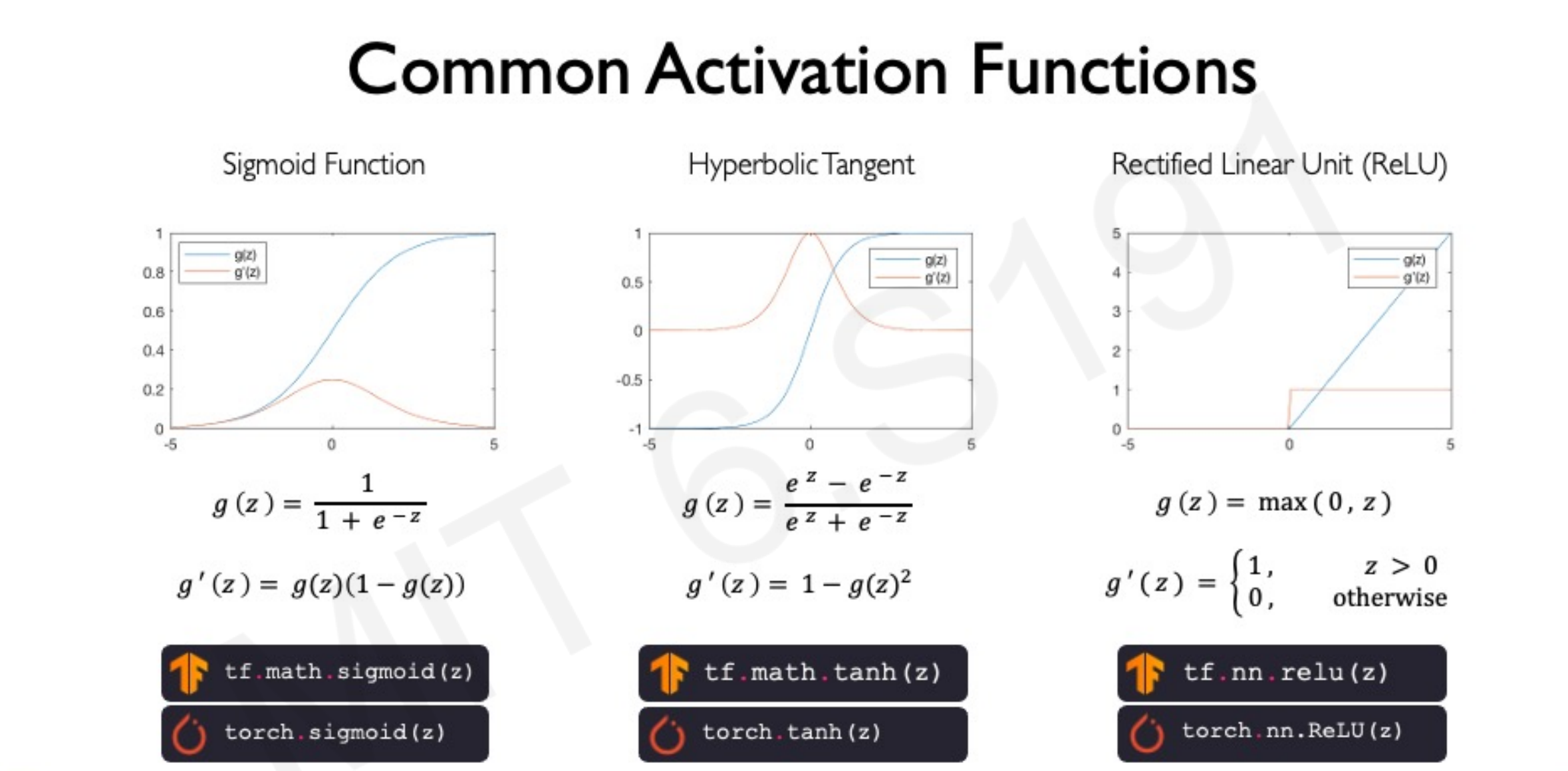

常见激活函数:

-

Sigmoid 函数:输出在 (0, 1) 之间,适用于二分类问题。

- 适合将输出转化为概率

-

ReLU 函数:输出非负值,计算简单,能有效缓解梯度消失问题。

-

三、神经网络的训练

1. 损失函数

- 定义:衡量模型预测值与真实值之间的差异。

- 这是学习的一个过程,没有学习过的网络就好像一个刚出生的婴儿

- 常见损失函数:

- 二元交叉熵损失:用于二分类问题。

- 均方误差损失:用于回归问题。

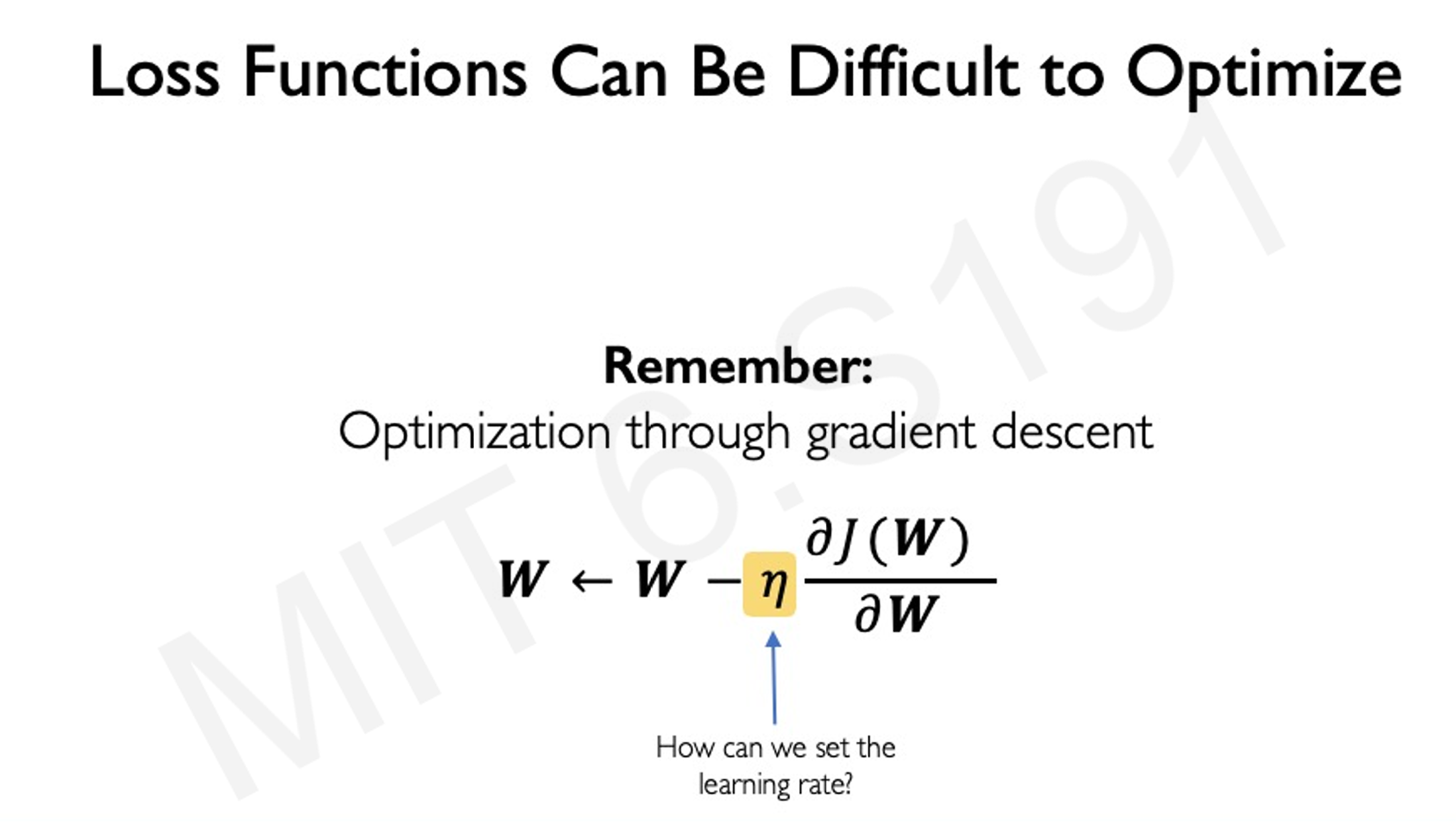

2. 优化算法

我们希望找到一个网络权重函数,可以实现最小的损失函数

- 梯度下降法:一种反向传播方法(我们一般通过反向传播来估算最优的权重和偏置)

- 原理:通过计算损失函数对权重的梯度,更新权重以最小化损失。

- 步骤:

- 随机初始化权重。

- 计算当前权重下的损失。

- 计算梯度,确定权重更新方向。

- 更新权重,重复直到收敛。

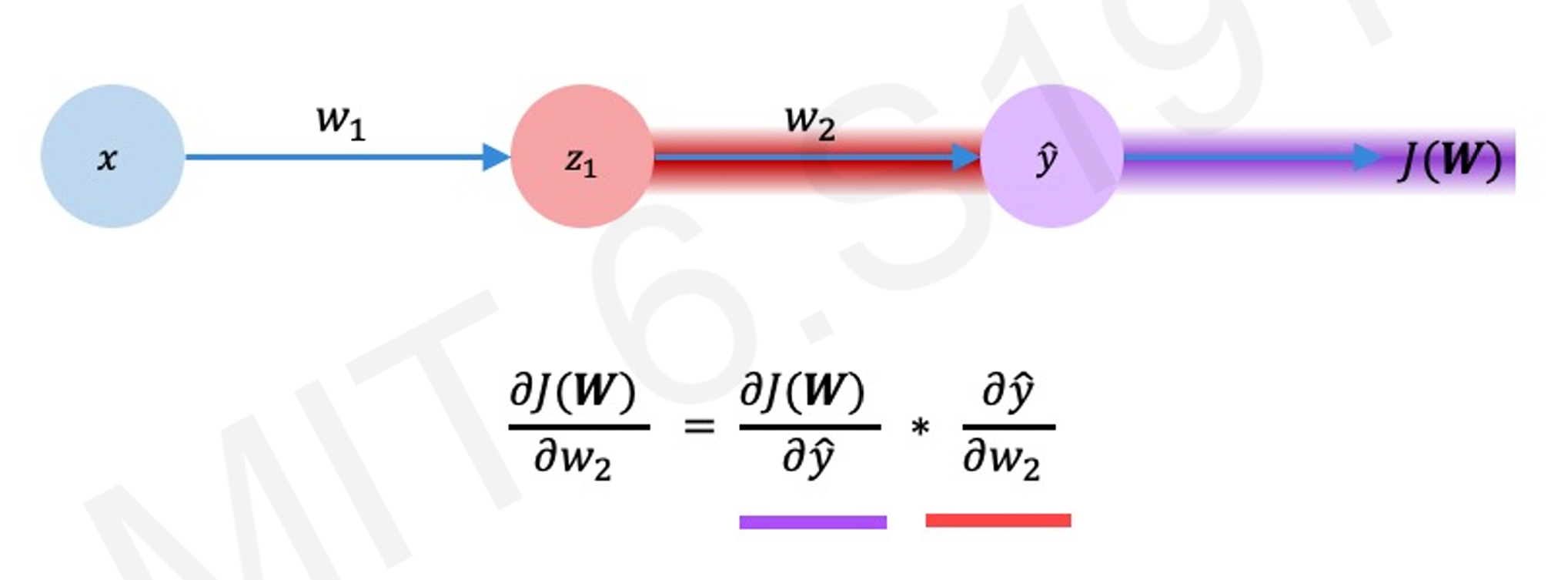

梯度计算,使用链式法则计算

-

随机梯度下降法(SGD):

- 原理:每次仅使用一个数据点计算梯度,更新权重。

- 优点:计算速度快,适用于大规模数据集。

- 缺点:更新过程较为嘈杂,可能导致不稳定。

-

小批量梯度下降法:

- 原理:每次使用一小部分数据(批量)计算梯度,更新权重。

- 优点:结合了梯度下降和随机梯度下降的优点,既保证了一定的计算效率,又具有较好的稳定性。

3. 学习率设置

- 学习率的作用:决定权重更新的步长大小。

- 设置原则:

- 学习率过大:可能导致权重更新过度,损失函数值波动大,训练不稳定。

- 学习率过小:权重更新缓慢,训练时间长,可能陷入局部最优。

- 如何解决学习率的选择

-

- 多次重复实验,找出最合适的学习率

-

- 设计一种自适应函数

-

四、过拟合与正则化

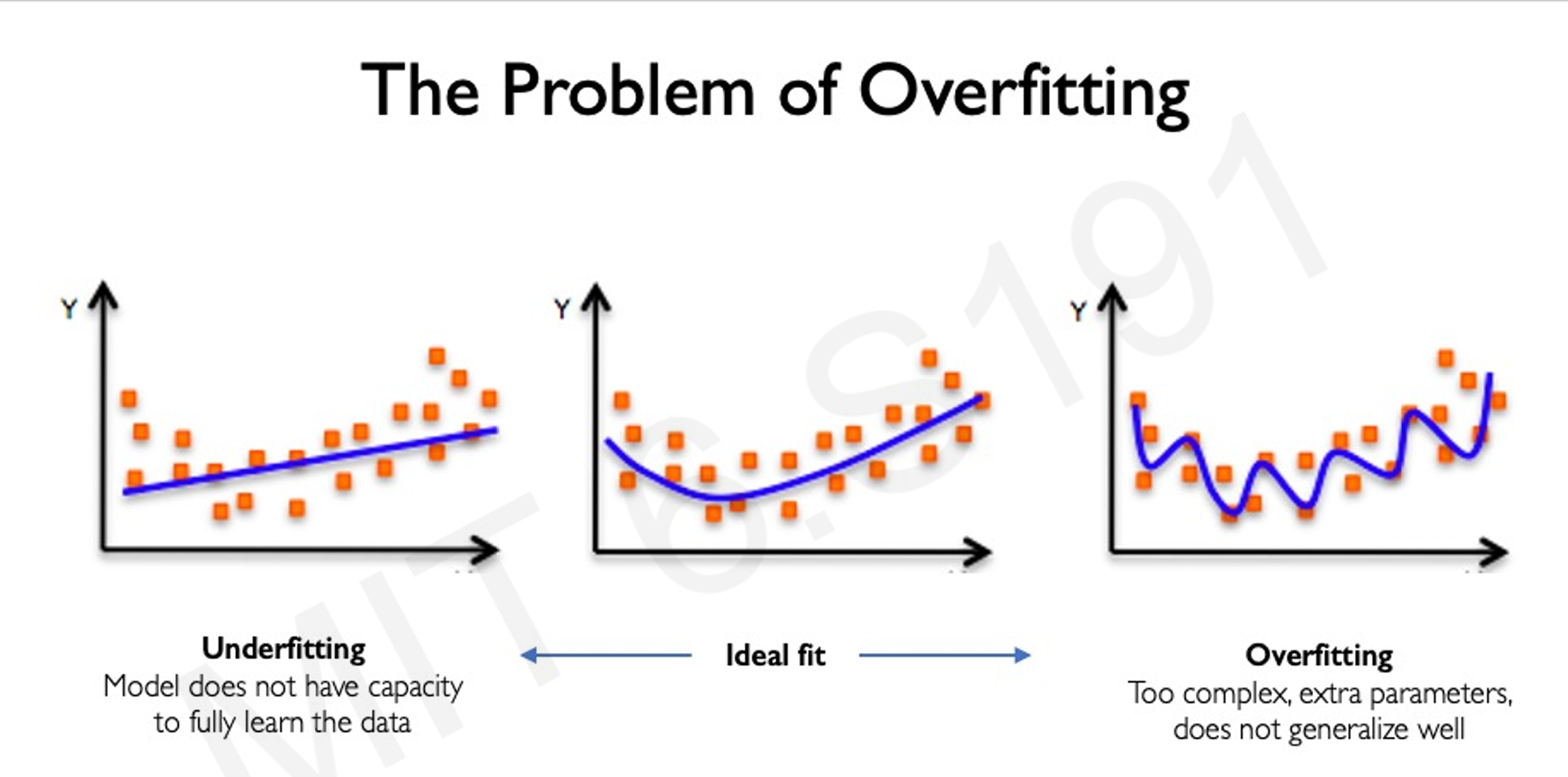

1. 过拟合的定义

-

现象:模型在训练集上表现良好,但在测试集上表现较差。

- 比如使用k210在训练对于方块的识别时候,如果使用的都是图像识别,一旦因为阴影和角度的不同,就会无法识别,哪怕训练集的识别率相当高。这种情况下一般通过形状识别

-

原因:模型过于复杂,对训练数据拟合过度,失去了泛化能力。

2. 正则化方法

-

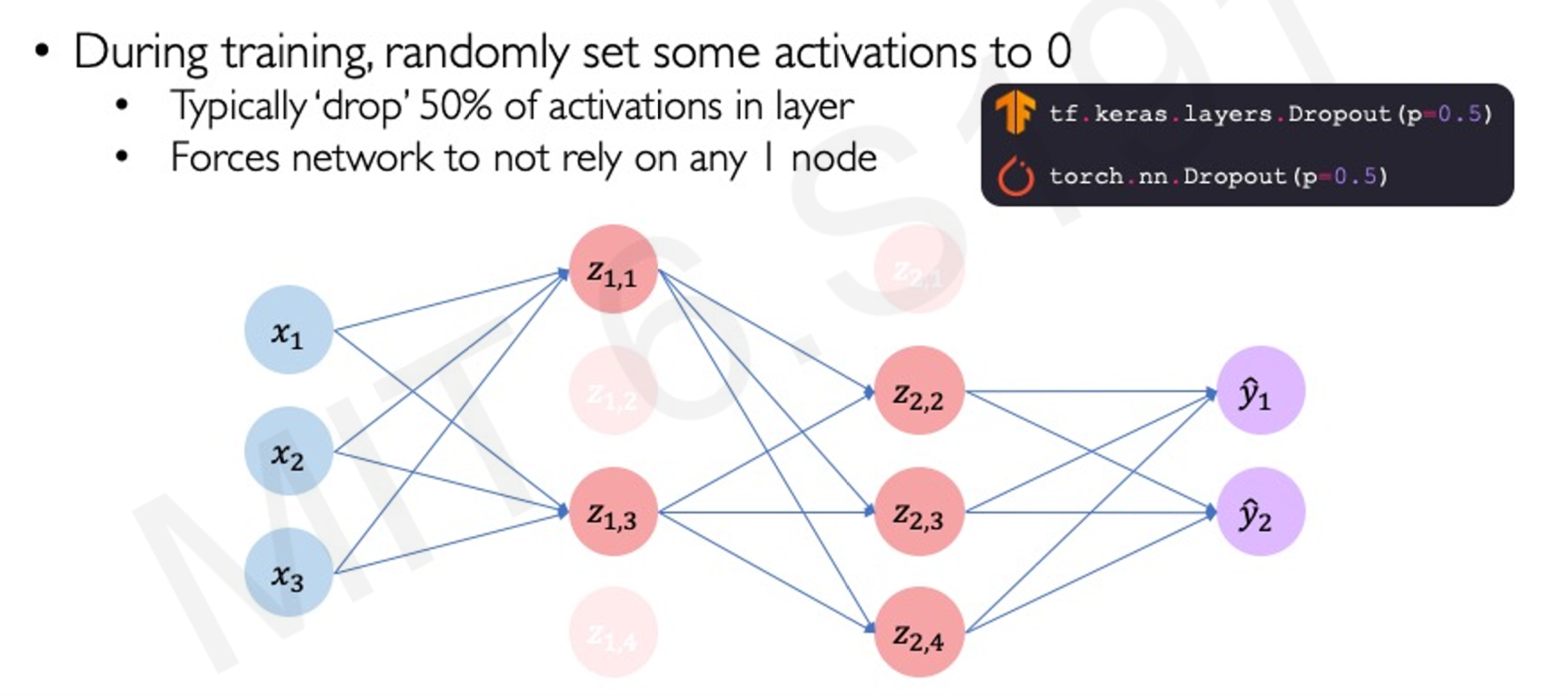

Dropout:

- 原理:在训练过程中随机丢弃一部分神经元,防止模型对某些神经元过度依赖。

- 作用:降低模型复杂度,提高泛化能力。

-

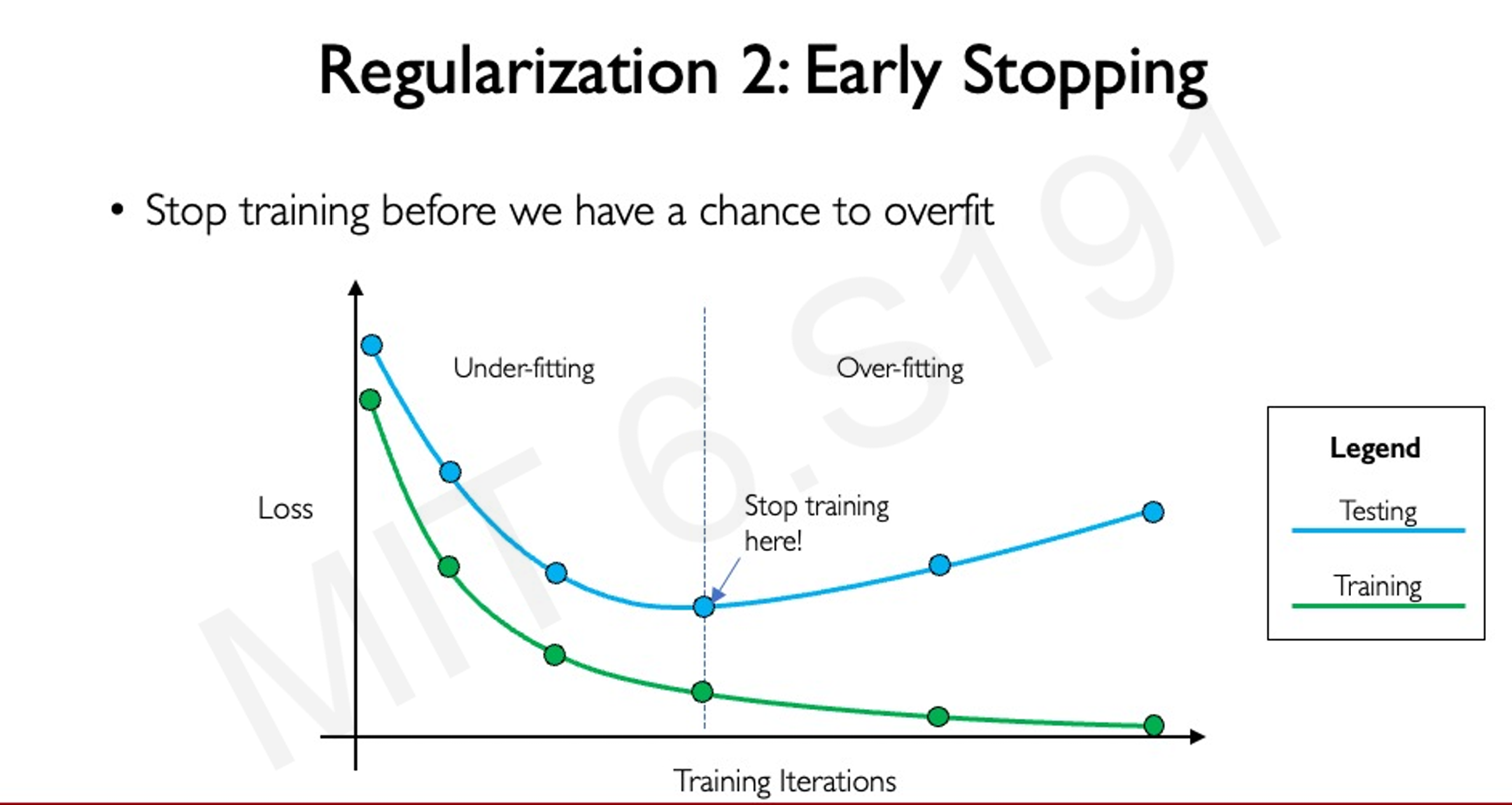

提前停止:

-

原理:在训练过程中监控验证集的损失,当损失开始上升时停止训练。

-

作用:避免模型过度拟合训练数据。

-

五、深度学习的实践应用

1. 音乐生成

- 任务:使用神经网络学习爱尔兰民谣的风格,并生成新的歌曲。

- 方法:构建一个循环神经网络(RNN),通过学习音乐数据中的模式,生成新的音乐序列。

2. 计算机视觉

- 任务:检测和缓解面部识别系统中的偏差。

- 方法:构建卷积神经网络(CNN),对图像数据进行特征提取和分类,识别面部特征并检测偏差。

3. 大型语言模型

- 任务:微调大型语言模型,评估模型质量。

- 方法:使用迁移学习,在特定任务上对预训练的语言模型进行微调,提高模型在特定领域的性能。

七、总结

通过本课程,学生将系统地学习深度学习的核心概念、原理和应用,并通过实践操作加深理解。课程内容涵盖了神经网络的基础知识、训练方法、过拟合与正则化等关键问题,以及深度学习在音乐生成、计算机视觉和大型语言模型等领域的实际应用。丰富的课程资源和强大的支持团队将为学生的学习提供有力保障。